Un grupo de más de mil profesionales con cargos y responsabilidades en muchos casos muy relacionadas con el ámbito de la tecnología han firmado una carta abierta en la que se pide expresamente a «todos los laboratorios de AI» que «pausen durante al menos seis meses el entrenamiento de todos sus sistemas más poderosos que GPT-4», refiriéndose al desarrollo de «experimentos gigantes en AI» y citando «profundos riesgos para la sociedad«.

Tan señaladas figuras en el entorno de la tecnología deberían entender que eso que piden no solo no puede ser, sino que además, es imposible. El hecho tecnológico es, en las sociedades humanas, completamente inevitable: la fantasía de que puede llegar un gobierno o algún tipo de figura y «prohibir que se hagan experimentos en AI» es completamente infantil y absurda. La tecnología nunca se ha detenido por ninguna consideración de ese tipo: el que descubrió que los seres humanos podíamos utilizar el fuego, controlarlo y beneficiarnos de sus propiedades no solo no pidió permiso a nadie, sino que, una vez descubiertas las particularidades de su uso, habría sido completamente imposible restringirlas o ponerlas bajo control, y eso que hablamos de una tecnología con efectos potencialmente devastadores. Cuando se descubrió la electricidad, de nada habría servido prohibirla: siempre habría habido alguien, en alguna jurisdicción o con alguna ambición determinada, que lo habría utilizado para tratar de obtener un beneficio.

El machine learning es, ahora, el protagonista de la última oleada de temores incontrolables: empezando por el uso de un término inadecuado, inteligencia artificial o AI, son muchos los que parecen creer que estamos ante una tecnología imposible de controlar, que es capaz de hacer cosas que excedan el control de los humanos. Ese tipo de extremos son completamente absurdos, como lo es el pretender referirse a esa tecnología como que «muestra atisbos de inteligencia general«. Este tipo de ensoñaciones afecta incluso a personas que trabajan directamente en este campo, como el reciente caso de Blake Lemoine y su obsesión enfermiza con la supuesta autoconsciencia del algoritmo en el que trabajaba.

No, ni LaMDA, ni GPT ni ningún otro algoritmo poseen autoconsciencia, y aunque la antropormorfización, el atribuir a cualquier cosa cualidades humanas sea, como la pareidolia, completamente inevitable, no debemos olvidar que estamos hablando de atribuciones e interpretaciones desarrolladas en nuestro cerebro, no de realidades. A finales de noviembre del pasado año, una compañía que había dado un paso importante, llevar los modelos de entrenamiento de un determinado tipo de algoritmos, los modelos masivos de lenguaje, a una escala inimaginable hasta entonces – la primera versión de ChatGPT fue entrenada en un superordenador hecho con unas 10,000 tarjetas gráficas Nvidia – tomó además la decisión de abrir su modelo conversacional a cualquier usuario, con el fin de que continuase su entrenamiento. Dado que hablábamos precisamente de eso, de un modelo conversacional que podía ser utilizado de manera completamente sencilla por cualquiera, no han sido pocos los que le han atribuido cualidades como la inteligencia, o los que han creído ver en las famosas «hallucinations« del algoritmo algún tipo de «rebeldía» o de «conciencia escondida».

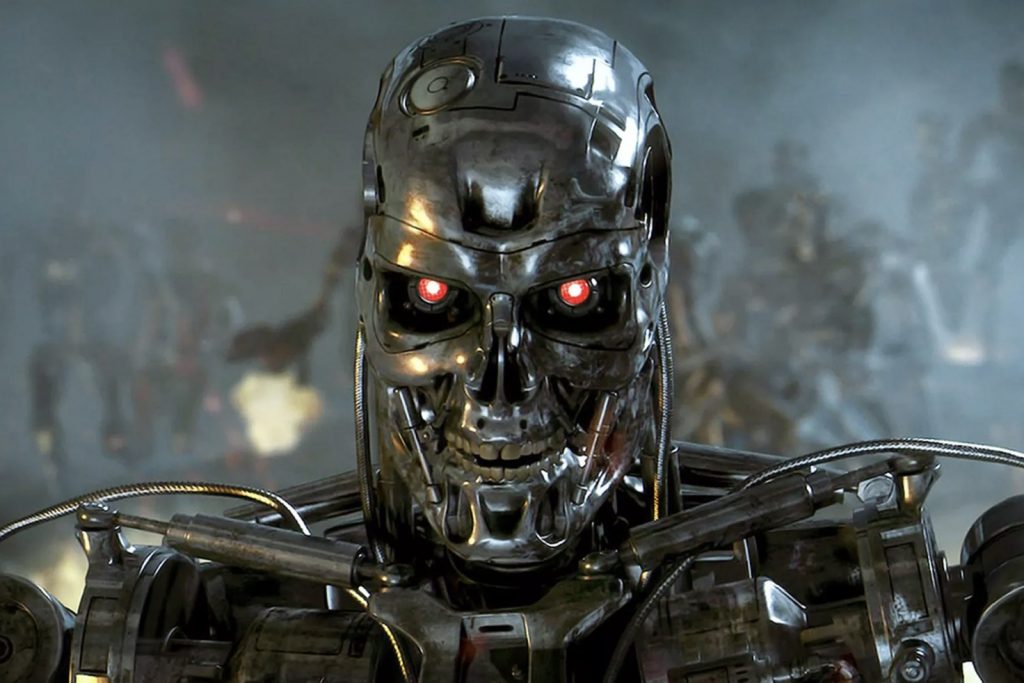

Pero no, no es así. Un modelo masivo de lenguaje no hace nada más que lo que hace cualquier algoritmo: aprender a relacionar conceptos y a formular frases con ellos. No piensa. No es inteligente. No es autoconsciente, ni siquiera consciente. Es, simplemente, una versión a una escala impresionante de la función de autocompletar textos de tu smartphone o de tu correo electrónico, que también puede parecerte en algunos momentos «inteligente» (y en otros, exasperantemente idiota). Es estadística, no inteligencia: simplemente, se trata de funciones estadísticas tan complejas y desarrolladas a una escala tan elevada, en modelos con tantos parámetros y con una memoria tan grande, que no podemos intentar seguirlos. Pero eso no los convierte en inteligentes, ni en capaces de tomar conciencia de sí mismos, ni mucho menos en Terminators que consideran que deben acabar con la humanidad. Eso es, simplemente, ciencia-ficción.

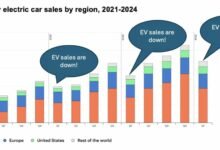

¿Conlleva el machine learning «profundos riesgos para la sociedad»? Pues indudablemente, una tecnología que algunos calculan que amenaza trescientos millones de puestos de trabajo puede suponer un riesgo, aunque también especulan que puede suponer un incremento del 7% del PIB global. El peligro para la sociedad tendrá más que ver con cómo se reparta ese incremento que con ninguna otra cosa: si, como ha ocurrido hasta ahora, se generan grandes disparidades en su reparto y se incrementan las brechas entre ricos y pobres, obviamente tendremos un serio problema, pero no debido a la tecnología, sino a la avaricia de algunos humanos. Si se envía al paro a millones de personas en industrias enteras y no se hace nada por ofrecerles alternativas, es evidente que surgirán problemas, pero la tecnología no será responsable de ellos.

La tecnología siempre ha provocado que determinados trabajos desaparezcan o sean sustituidos por máquinas. No es algo nuevo. Y sobre todo, es completamente inevitable: en cuanto su desarrollo se convierte en factible y bajan sus barreras de entrada, la adopción deja de ser voluntaria y pasa a ser obligatoria: el que no adopta la tecnología cuando el resto de su industria lo hace, se queda fuera de su mercado. ¿Más regulación? Tal vez, con todo lo que conlleva que regulen el fenómeno una serie de políticos que no suelen tener ni la más ligera idea, ni siquiera mínimamente aproximada, de lo que hablan. ¿Más responsabilidad y precauciones, sobre todo en la aplicación a determinados usos? Por supuesto. Pero según lo que sabemos de casos anteriores, va a estar complicado. Buena suerte.

Desde la aparición de GPT hasta ahora hemos visto como toda una explosión de financiación hacía posible la aparición de cientos de compañías dedicadas al desarrollo de modelos masivos de lenguaje, hasta convertirlos en una nueva religión: venir ahora, en plena competencia salvaje y desenfrenada, a pedir que pausen su desarrollo durante seis meses es, independientemente de la calidad de las firmas que tenga detrás la carta abierta en cuestión, una soberana estupidez. Y no va a pasar.

This article is also available in English on my Medium page, «A ‘pause’ on the development of AI? It’s not going to happen»