Hoy es un gran día para los que estamos interesados en el campo de los modelos de lenguaje, ya que Microsoft ha presentado un nuevo modelo LLM de 1,58 bits, una propuesta que promete mejorar la relación entre el rendimiento y el coste de los sistemas de inteligencia artificial.

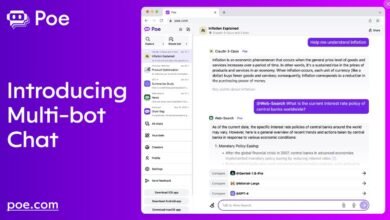

Antes de explicárselo a mi abuela, para que todo el mundo lo entienda (y entienda por qué es importante), voy con la noticia: Microsoft ha dado un paso adelante al introducir un modelo de lenguaje, el BitNet b1.58, que redefine la manera en que entendemos el almacenamiento y procesamiento de datos en IA.

Tradicionalmente, los modelos de lenguaje utilizan valores de 16 bits para representar cada uno de sus parámetros o ‘pesos’. Sin embargo, este nuevo enfoque emplea tan solo 1,58 bits por parámetro, limitando los valores posibles a -1, 0 o 1. La implicación más directa de este cambio es una reducción drástica en el uso de la memoria y, por ende, en el consumo energético, lo que se traduce en una mayor eficiencia y reducción de costes. Me parece fascinante cómo esta tecnología no solo mantiene, sino que potencialmente mejora, el rendimiento comparado con los modelos más tradicionales a pesar de su simplificación numérica.

Lo que me parece especialmente prometedor de BitNet b1.58 es cómo abre la puerta a una nueva generación de hardware especializado. Imaginad dispositivos optimizados para ejecutar estos modelos de forma más eficiente, lo que podría democratizar aún más el uso de tecnologías de IA avanzadas en diferentes sectores y dispositivos.

Por otro lado, la investigación de Microsoft sugiere que este modelo podría manejar secuencias de datos más largas de manera nativa, lo que amplía sus posibles aplicaciones, desde asistentes virtuales hasta análisis de texto avanzado.

El documento de Microsoft también plantea la posibilidad de explorar técnicas de compresión sin pérdidas aún más avanzadas. Esto indica que estamos apenas al inicio de lo que podría ser una nueva ola de innovaciones en el campo de la inteligencia artificial, donde la eficiencia no compromete el rendimiento.

Ahora sí, a por mi abuela

Se ha creado una nueva forma para que las computadoras entiendan y procesen el lenguaje humano, una forma mucho más sencilla que la que existía hasta ahora.

Imagina que tienes una caja de lápices de colores, pero en lugar de tener muchos colores diferentes, solo tienes tres: uno para dibujar cosas oscuras, otro para cosas claras, y uno más para no colorear nada. Microsoft ha encontrado una forma de enseñar a las computadoras a entender y responder preguntas usando algo parecido a esta caja de tres colores, lo cual es mucho más sencillo que usar una caja con cientos de colores.

Este nuevo método es muy importante porque permite que las computadoras hagan su trabajo usando menos energía, algo así como si pudieras iluminar tu casa igual de bien, pero con bombillas que consumen mucha menos electricidad. También, estas computadoras pueden ser más pequeñas y sencillas, como si en lugar de un armario grande para guardar tus cosas, necesitaras solo una cajita.

Con esta nueva técnica, las computadoras pueden ayudarnos en muchas tareas, como traducir idiomas, responder preguntas, o incluso hacer que los dispositivos electrónicos en casa sean más inteligentes. Es como si les enseñaran a ser más listas, pero sin necesidad de tanto espacio o tanta energía. En el futuro podríamos tener pequeños aparatos en casa que nos ayuden en muchas tareas, haciendo todo más fácil y cómodo, pero con un gran cerebro.

Referencias

- The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits https://arxiv.org/pdf/2402.17764.pdf