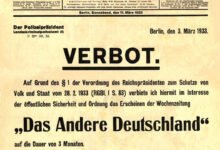

Me llamó la atención una noticia de Ars Technica en la que dan cuenta de cómo el metro de Londres está comenzando a utilizar algoritmos para examinar en tiempo real las imágenes obtenidas por su red de cámaras de seguridad, con la idea de detectar de manera automatizada circunstancias que van desde pasajeros que entran sin el correspondiente título de transporte, a posibles situaciones de violencia, comisión de posibles crímenes, detección de posibles armas, o cualquier tipo de inseguridad.

Que los algoritmos pueden, efectivamente, ser utilizados con ese propósito es algo que sabemos desde hace mucho tiempo: de hecho, compañías como Google han estado utilizando los miles de millones de vídeos etiquetados en YouTube como fuente de entrenamiento para sus algoritmos. Sin embargo, los usos de este tipo de algoritmia en tiempo real han sido más escasos, aunque todo parece indicar que se generalizarán en el futuro.

El metro de Londres cuenta con una red enormemente extensa de cámaras de vigilancia, que ahora pasarán a analizar sus imágenes en cada décima de segundo. Monitorizarlas todas ellas de manera sistemática supondría una importante dedicación de recursos, lo que conlleva que, en la mayoría de los casos, su uso se limite a servir como prueba una vez que la situación ya ha tenido lugar. Generalmente son los propios servicios de vigilancia o incluso los pasajeros los que denuncian situaciones de peligro o inseguridad, con la lentitud de actuación que esto puede conllevar.

Si las propias cámaras son capaces de detectar ese tipo de situaciones y de generar una alerta de manera automatizada, eso podría servir para generar respuestas más rápidas y reducir el posible impacto en la seguridad del transporte colectivo. Sin embargo, surgen también otras cuestiones, tales como el tratamiento de los falsos positivos, además, por supuesto del posible impacto sobre la privacidad. Por el momento, parece que la prueba no incluirá tecnologías de reconocimiento facial, aunque su uso no está descartado en el futuro. Pero veremos qué ocurre cuando se lancen alertas por cuestiones triviales, como un grupo de jóvenes que bromea empujándose, con alguien que simplemente se estira y levanta los brazos, o con muchas otras posibles situaciones que puedan ser reconocidas como violentas aunque, en realidad, respondan a comportamientos perfectamente aceptables.

Pasar de estar permanentemente vigilados en los espacios públicos a que esos mismos dispositivos analicen algorítmicamente todos los patrones de nuestro comportamiento y emitan alertas en caso de detectar algo que puedan asociar con un comportamiento peligroso es algo cuya evolución tendremos que ver a lo largo del tiempo, y tratar de entender si el fin perseguido, incrementar la seguridad en esos lugares públicos, justifica los medios utilizados.

This article is also available in English on my Medium page, «Using algorithms to interpret surveillance camera footage: the thin end of the wedge?»