Mi columna en Invertia de esta semana se titula «¿La manzana inteligente?» (pdf), y es un intento de explicar la estrategia de Apple en un ámbito, el de la inteligencia artificial, en el que no tiene las cosas para nada fáciles.

La presentación de apertura de la compañía en su WorldWide Developers Conference (WWDC) de este año sirvió fundamentalmente para que tratase de solucionar el problema reputacional que supone, a mediados de 2024, tener mucha menos inteligencia artificial incorporada a sus productos que sus competidores, y hacerlo de una manera en la que no se evidenciasen las carencias de la compañía. Básicamente, intentar hacer de la necesidad virtud, algo muy complicado en entornos tecnológicos.

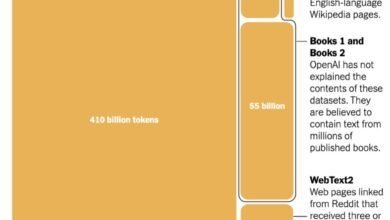

¿Dónde está el problema fundamental de Apple? Que, debido a su extrema política de respeto a la privacidad, una de las cuestiones que la compañía más explota en términos de imagen y diferenciación, cuenta con una generación de datos derivada de sus operaciones infinitamente inferior a la que pueden conseguir compañías como Meta, Google, Microsoft y otras. Ya en el año 2015 se decía que las políticas de privacidad de Apple repelían a los científicos de datos que trabajaban en ese ámbito, hasta el punto de que, a pesar del atractivo de trabajar en la marca de la manzana, preferían aceptar ofertas de otras compañías en las que tuvieran más datos con los que trabajar. La realidad es que la situación desde entonces no ha cambiado, salvo por una cuestión: la llegada de la muy ineficiente algoritmia generativa, que hace que esas necesidades de datos se disparen hasta prácticamente el infinito, lo que agrava el problema de la compañía.

Visto así, ¿qué podía hacer Apple? Básicamente, jugar con la A de su marca y llamar a su alternativa «Apple Intelligence» para jugar con las siglas AI, y posicionarla como «AI for the rest of us«, es decir, la inteligencia artificial para los que no quieren complicarse la vida con la tecnología, pero quieren tener algunas funcionalidades que utilizar en su día a día. Y, sobre todo, no sentirse inferiores a los que tienen dispositivos de otras marcas. Aburrida y práctica… pero eso no es necesariamente malo. Lo dejamos al final, le dedicamos un ratito después de haber cansado a los asistentes con la interminable sucesión de plataformas de la compañía, y lo vestimos como algo maravilloso como solo Apple sabe hacerlo.

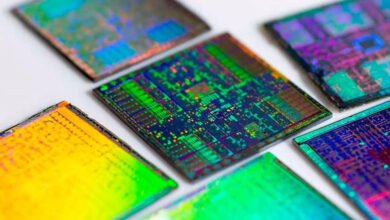

Visto así, el enfoque es claro: se desarrollan prestaciones de inteligencia artificial básicas que funcionan on device, en el mismo dispositivo, sin comprometer para nada la privacidad. Básicamente, machine learning sencillito. Pero como eso, por muy buenos que sean los procesadores de los iPhone, sólo da de sí lo que da de sí, se desarrolla un segundo nivel para determinadas consultas que funciona sobre servidores de Apple, con Apple Silicon, y que se comportan como lo hacían hasta ahora los de, por ejemplo, Apple Maps: se recibe la consulta, se responde, y se borra a los diez minutos. Tus datos no se almacenan y no son accesibles ni para la propia compañía.

Aún así, la situación es clara: no hay manera de que una compañía que renuncia a los poderosísimos chips de Nvidia, convertidos en estándar del mercado, sea capaz de rivalizar en prestaciones con los algoritmos de sus competidoras. Por tanto, el tercer nivel de oferta a los usuarios de Apple es que disparen sus consultas gratuitamente a ChatGPT 4o mediante un acuerdo que engordará bastante las arcas de OpenAI y le da un espaldarazo como líder de la industria: los usuarios preguntan, su dispositivo les avisa de que su información va a rebasar los muros de Apple y por tanto, está expuesta al uso que OpenAI quiera hacer de ella, pero reciben una respuesta similar a la que obtendrían si simplemente abriesen su app de ChatGPT y tecleasen su prompt ahí. Además, Apple ha afirmado estar en disposición de ofrecer a sus usuarios otros algoritmos a medida que llegue a acuerdos con las compañías que los explotan. ¿Que se enfada Elon Musk? Ya se le pasará.

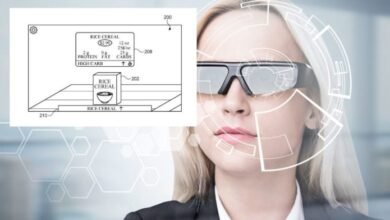

¿Buena solución? No, pragmatismo. Si lo acompañamos de un poco de maquillaje a la ya vieja Siri para que no parezca tan comparativamente tonta (afortunadamente para la compañía, ahí sigue la Alexa de Amazon, que es aún más limitada), y construimos la posibilidad de trabajar cross-app, algo que beneficia tanto al usuario como a los desarrolladores de aplicaciones (no olvidemos que esto era el WWDC, y su público son ellos), podemos construir una plataforma, con sus APIs y sus herramientas de desarrollo, que permite fácilmente que cualquier app recurra a una inteligencia artificial razonable, capaz de mejorar su propuesta de valor. Y de paso, se estimula a los usuarios a que actualicen su tecnología y sus dispositivos para poder acceder a este tipo de prestaciones.

Puestos a convertir limitaciones en ventajas, la jugada no es del todo mala, como mucho un tanto obvia. Y mientras tanto, Apple seguirá confiando en que l desarrollo de la inteligencia artificial del futuro se haga un poco más, valga la redundancia, inteligente, y deje de pretender resolver las limitaciones del aprendizaje con cantidades ingentes y desmesuradas de datos, para optar por otro tipo de modelos más eficientes. Porque en el juego de la fuerza bruta de los datos, Apple tiene más bien poco que hacer.