La creación de un archivo robots.txt es esencial para controlar cómo los motores de búsqueda, rastreadores web y bots de IA interactúan con tu sitio. Aquí te presentamos una guía sencilla para que puedas generar y gestionar tu archivo robots.txt de manera eficiente.

¿Qué es un archivo robots.txt?

El archivo robots.txt es un archivo de texto que se coloca en el directorio raíz de tu sitio web. Su función principal es indicar a los rastreadores web qué partes de tu sitio pueden o no pueden ser exploradas e indexadas. Este control es crucial para mejorar el SEO y proteger secciones sensibles de tu sitio.

Características Clave del Generador de Robots.txt

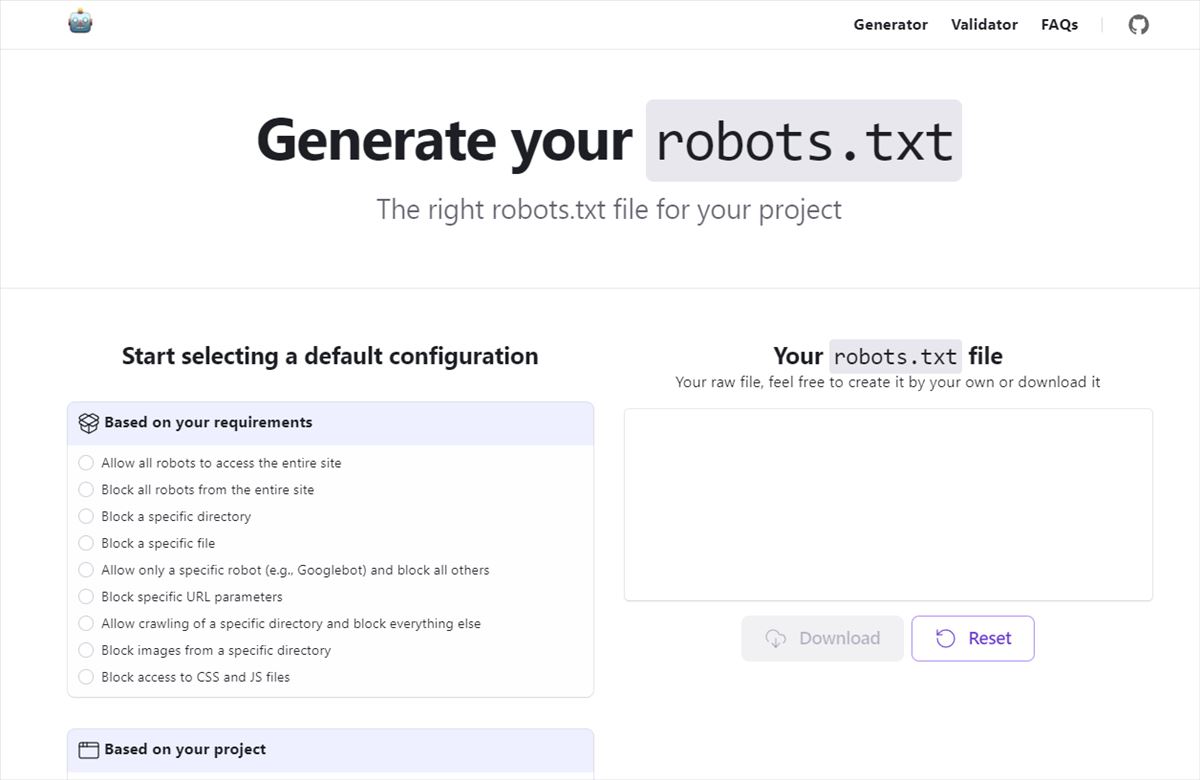

Os voy a hablar de un generador ede archivos robots que está disponible en generaterobotstxt.com.

Interfaz Fácil de Usar

Este generador ha sido desarrollado con Next.js y Radix UI para ofrecer una interfaz intuitiva. No necesitas ser un experto técnico para crear tu robots.txt, ya que la herramienta guía el proceso paso a paso.

Bloqueo Personalizado de Bots de IA

Puedes seleccionar y bloquear bots específicos, como GPTBot o Google-Extended, evitando que accedan a tu sitio. Esto es especialmente útil para proteger datos sensibles o evitar sobrecarga de tráfico no deseado.

Integración de Sitemap

Añadir tu URL de sitemap al archivo robots.txt ayuda a los motores de búsqueda a encontrar e indexar tu contenido más importante. Esto optimiza la indexación y mejora la visibilidad de tu sitio en los resultados de búsqueda.

Salida Descargable

Una vez configurado tu archivo, puedes descargarlo con un solo clic. Esta función facilita la implementación inmediata en tu sitio web.

Validador

El validador integrado verifica que tu archivo esté correctamente formateado. Esto asegura que los rastreadores web lo interpreten correctamente, evitando errores que podrían afectar tu SEO.

Configuraciones Predeterminadas

El generador ofrece varias configuraciones predeterminadas que puedes ajustar según tus necesidades:

- Permitir a todos los robots acceder a todo el sitio

- Bloquear todos los robots de todo el sitio

- Bloquear un directorio específico

- Bloquear un archivo específico

- Permitir solo a un robot específico (por ejemplo, Googlebot) y bloquear a los demás

- Bloquear parámetros de URL específicos

- Permitir el rastreo de un directorio específico y bloquear todo lo demás

- Bloquear imágenes de un directorio específico

- Bloquear acceso a archivos CSS y JS

Configuraciones Especializadas para CMS

Si usas un CMS como WordPress, Shopify o Magento, el generador incluye configuraciones optimizadas para estos sistemas. Esto facilita la creación de un robots.txt que cumpla con las mejores prácticas de cada plataforma.

Opciones Adicionales

Bloquear o Permitir Bots de IA

El generador permite bloquear o permitir bots de IA específicos. Puedes gestionar el acceso de bots como ClaudeBot, Omgilibot, FacebookBot, entre otros, según tus necesidades.

URL del Sitemap

Incluir la URL de tu sitemap en el archivo robots.txt es fundamental para mejorar la eficiencia del rastreo de tu sitio. Esto facilita que los motores de búsqueda indexen tu contenido relevante.

En su web ponen algunas de las preguntas frecuentes que vale la pena tener en cuenta:

Preguntas Frecuentes

¿Cómo enviar un archivo robots.txt a los motores de búsqueda?

No es necesario enviar el archivo robots.txt directamente. Los rastreadores lo buscarán automáticamente al explorar tu sitio. Si haces cambios y quieres notificar a Google, puedes usar Google Search Console para enviar el archivo.

¿Cómo añadir el archivo robots.txt a mi sitio web?

Debes colocar el archivo en el directorio raíz de tu sitio web, accesible en https://tusitio.com/robots.txt. Si no tienes acceso a este directorio, contacta a tu proveedor de alojamiento web.

¿Cómo usar la directiva Allow correctamente?

La directiva Allow permite acceso a un archivo o carpeta dentro de un directorio bloqueado. Úsala junto con Disallow para especificar excepciones dentro de áreas bloqueadas de tu sitio.

¿Cómo definir el User-agent?

Especifica el nombre del bot al que le das instrucciones con la directiva User-agent. Para aplicar las reglas a todos los rastreadores, usa un asterisco (*). Para permitir solo a Googlebot, usa:

User-agent: Googlebot

Sintaxis del archivo robots.txt

Cada directiva debe comenzar en una nueva línea con un solo parámetro por línea. Asegúrate de que los nombres de las carpetas coincidan exactamente con su ortografía en el sitio web, ya que la sintaxis es sensible a mayúsculas y minúsculas.

Contribuir al Proyecto

Este proyecto es de código abierto y acepta contribuciones. Puedes agregar nuevas funciones, corregir errores o mejorar el código existente en el repositorio de GitHub.