Cuando OpenAI fue fundada en 2015, Google ya llevaba algunos años reflexionando sobre el desarrollo del machine learning en un entorno con unos recursos de computación cada vez más potentes y más ubicuos, ya había dado el paso de adquirir la Deep Mind de Demis Hassabis, y estaba formando a todo su personal en estas tecnologías.

Sin embargo, esa ventaja, siguiendo al pie de la letra el fantástico libro de Clayton Christensen «El dilema del innovador«, no le sirvió para mucho: el hecho de ser la compañía líder en búsqueda llevó a que mostrase inacabables resistencias a implantar la tecnología en sus productos – a pesar de haber afirmado que estaba literalmente «repensándolos todos» para incluirla, – resistencias que llevaron a lo que hoy ya sabemos que pasó: que una compañía mucho más joven como OpenAI y otra más veterana pero que no había hablado mucho del tema, Microsoft, adelantasen a Google por la derecha.

¿Razones? La primera y más evidente era que, ante una tecnología incipiente que aún no estaba completamente bajo control y que, por razones estadísticas, tendía a crear artefactos a partir de correlaciones escasamente significativas, el riesgo de credibilidad que potencialmente corría Google era muchísimo mayor que el que podían correr sus competidores. ¿Qué ocurre si el motor de búsqueda que usas para prácticamente todo, de la noche a la mañana, empieza a «alucinar pepinillos» y a decirte que le eches pegamento a tu pizza, que hagas deporte corriendo con unas tijeras en la mano mientras te ríes, o que le cambies el aceite a tus altavoces? Pues que muy posiblemente, en lugar de simplemente reírte y descartar la respuesta – si tienes suficiente sentido crítico como para descartarla, y no eres de los que hace siempre lo que Google dice – es muy posible que pienses que en Google se han vuelto locos y que pierdas toda tu confianza ya no en esos resultados, sino en el motor de búsqueda en su conjunto.

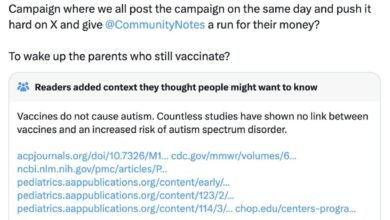

Desde que Google anunció la llegada de sus AI Overview, la incorporación de respuestas generadas por su algoritmo en sus páginas de búsquedas, eso es básicamente lo que está pasando: respuestas que interpretan memes y chistes como si fueran información fidedigna, que no son capaces de captar la ironía (Sheldon Cooper, ¿estás ahí en el equipo de desarrollo?) o que directamente elaboran resultados a partir de correlaciones espurias, poniendo la fiabilidad del buscador en constante entredicho. Y para terminar de fastidiarla, derivando posibles responsabilidades sobre una respuesta que Google no ha simplemente recopilado de otra fuente, sino que la ha fabricado ella misma.

Si desarrollas una funcionalidad y lo primero que te encuentras es que los usuarios se instalan un plugin específicamente diseñado para eliminarla porque la consideran annoying, molesta, no parece muy buena señal. Google tiene ahora un importante reto ante sí: incorporar una tecnología que conoce, pero de cuyas limitaciones es perfectamente consciente, y hacerla compatible no solo con la confianza que sus usuarios tienen en su producto principal, sino también con su modelo de negocio y con su estructura de costes. Y ninguno de esos retos es en absoluto sencillo.

This article is also available in English on my Medium page, «How long can Google keep kicking the AI can down the road?»